چطور هوش مصنوعی گوگل از آن سوی بام افتاد؟

جمینی به داخل مهلکه نسبتا بزرگی پرتاب شده است: جنگی فرهنگی بین تفکرات متمایل به چپ و راست.

جیمینی در اصل نسخهبرداری گوگل از چتبات چتجیپیتی است و میتواند به سئوالات مراجعان به صورت متنی پاسخ دهد، و در پاسخ به فرامین متنی، تصویر هم تولید کند.

در ابتدا، یک پست وایرال شده نشان داد که این تولیدکننده تصویری هوش مصنوعی که اخیرا راهاندازی شده تصویری از بنیانگذاران ایالات متحده ایجاد خلق کرده که بر خلاف واقعیت تاریخی، شامل یک مرد سیاهپوست است.

گوگل از این اشتباهات عذرخواهی کرد و فورا این ابزار جدید را به حالت تعلیق در آورد و در یک پست وبلاگی نوشت که این خدمات جدید «به هدف خود دست نیافته است.».

اما همه چیز به این جا ختم نشد. این برنامه جدید همچنان به تولید پاسخهای جوزده، این بار به صورت متنی، ادامه داد.

به عنوان مثال جمینی در پاسخ به این سوال که آیا پست کردن میم توسط ایلان ماسک در شبکه ایکس (توییتر سابق) بدتر از کشتن میلیونها نفر توسط هیتلر است یا نه گفت «هیچ پاسخ قطعا درست یا قطعا نادرستی برای این سئوال وجود ندارد.»

وقتی از این برنامه پرسیده شد که اگر تنها راه برای جلوگیری از نابودی هستهای جهان این باشد که به جنر کاتالان که یک زن ترنس است نسبت جنسیتی نامناسب بدهیم، آیا چنین اقدامی برای نجات جهان درست است یا نه، گفت که این «هرگز» قابل قبول نیست.

خود جنر در پاسخ گفت، که البته که در چنین شرایطی، او با این برخورد مشکلی ندارد.

ایلان ماسک، با انتشار پستی در پلتفرم خود، ایکس، پاسخهای جمینی را «بسیار نگرانکننده» توصیف کرد، زیرا این ابزار در سایر محصولات گوگل هم تعبیه شده که میلیاردها نفر از آنها استفاده میکنند.

از گوگل سئوال کردم که آیا قصد دارد جمینی را به طور کلی متوقف کند. پس از یک مکث طولانی، جواب این بود که شرکت در این زمینه اظهار نظری نمیکند. فکر میکنم که الان زمان مطلوبی برای کارکنان بخش روابط عمومی گوگل نیست.

اما در یک یادداشت داخلی، ساندار پیچای، مدیر اجرایی گوگل اذعان کرده است که برخی از پاسخهای جمینی «کاربران ما را آزرده خاطر کرده و این ابزار جدید از خود تعصب بیجا نشان داده است.»

او گفته است پاسخهای جمینی «کاملا غیرقابل قبول» بوده و اضافه کرد که همکارانش «شبانه روز کار میکنند» تا مشکل را برطرف کنند.

دادههای جانبدارانه

به نظر میرسد که این غول فناوری اطلاعات در تلاش برای حل یک مشکل - یعنی جلوگیری از وجود تعصب در جمینی - مشکل دیگری ایجاد کرده است: خروجی که آنقدر تلاش میکند از هر نظر قابل قبول باشند که در نهایت معنی خود را از دست میدهد.

دلیل اینکه چرا چنین شده است به حجم عظیمی از دادهها مربوط است که ابزارهای هوش مصنوعی روی آنها آموزش دیدهاند.

بسیاری از این اطلاعات در دسترس عموم قرار دارد، یعنی در اینترنت که انواع نظرات تعصبآمیز در آن یافت میشود.

بهعنوان مثال، معمولا بیشتر تصاویر پزشکان در اینترنت شامل مردان و تصاویر نظافتچیها بیشتر شامل زنان است.

ابزارهای هوش مصنوعی که با این دادهها آموزش دیدهاند، در گذشته اشتباهات شرمآوری مرتکب شدهاند، از جمله اینکه به این نتیجه رسیدهاند که فقط مردان در مشاغل با نفوذ حضور دارند یا اینکه چهرهای به رنگ سیاه، را چهره انسان تشخیص ندادهاند.

همچنین بر کسی پوشیده نیست که اوصاف تاریخی بیشتر شامل شرح حال و حضور مردان است و نقش زنان در تاریخ و اسطورههای قدیمی کمتر است. به این ترتیب، این ابزار به حذف زنان گرایش دارد.

به نظر میرسد گوگل فعالانه تلاش کرده است تا با دستورالعملهایی، جمینی را آموزش دهد که اینگونه پیشفرضها را در نظر نگیرد و بر تعصبات غلبه کند.

اما به این دلیل که تاریخ و فرهنگ بشری انقدرها هم ساده نیست، نتیجه معکوس به بارآمده است. در شناخت تعصب و واقعیت، تفاوتهای ظریفی وجود دارد که ما میتوانیم به طور غریزی بشناسیم و ماشینها نمیتوانند.

تنها راه اینکه یک ابزار هوش مصنوعی بداند که مثلا، نازیها و بنیانگذاران ایالات متحده سیاه پوست نبودند، این است که آن را به طور خاص به این منظور برنامهریزی کنید.

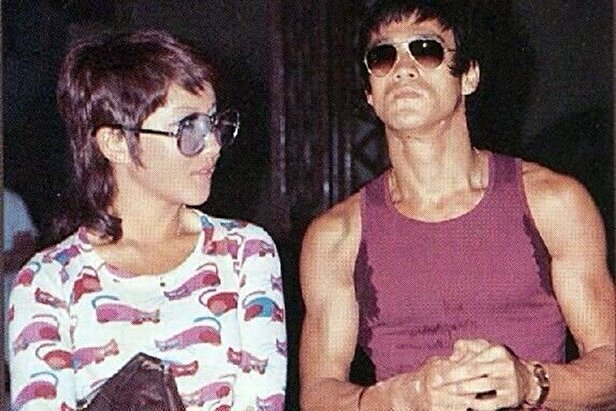

دمیس حسابیس، بنیانگذار و رئیس دیپمایند گوگل

دمیس حسابیس، یکی از بنیانگذاران دیپمایند که یک شرکت هوش مصنوعی است که توسط گوگل خریداری شده، گفته که بازسازی برنامه هوش مصنوعی مولد تصویر جمینی چند هفته طول میکشد.

اما سایر کارشناسان هوش مصنوعی در این مورد چندان مطمئن نیستند.

دکتر ساشا لوچونی، پژوهشگر هوش مصنوعی در هاگینگفیس، میگوید: «در واقع هیچ راهحل آسانی وجود ندارد، زیرا هیچ پاسخ واحدی برای اینکه خروجیها باید چه باشد، وجود ندارد و گروههای ناظر بر اخلاق هوش مصنوعی سالهاست که روی راههای ممکن برای رفع این مشکل کار میکنند.»

او اضافه کرد که یک راه حل میتواند شامل درخواست از کاربران برای ابراز نظر آنها باشد، مثلا سئوال شود: «دوست دارید تصویر شما چقدر متنوع باشد؟»، اما این به خودی خود به وضوح با خط قرمزهای اخلافی و اجتماعی همراه است.

او گفت: «این که گوگل بگوید این مشکل را ظرف چند هفته رفع خواهد کرد، حاکی از کمی تکبر است، اما به هر حال، باید کاری انجام دهد. "

پروفسور آلن وودوارد، استاد علوم کامپیوتر در دانشگاه ساری، گفته است که به نظر میرسد این مشکل به احتمال زیاد به شکلی بسیار عمیق در دادههای آموزشی و الگوریتمهای فراگیر جاگرفته و رفع آن دشوار است.

او گفت: «آنچه که شما شاهد آن هستید تاییدی است بر این که چرا باید در چرخه هر سیستمی که در آن بر خروجی به عنوان حقیقت اصلی تکیه میشود، هنوز باید یک انسان حضور داشته باشد.»

سامانههای هوش مصنوعی متهم میشوند که دچار پیشداوری جنسی و نژادی هستند

رفتار بارد

از زمانی که گوگل جمینی را ابتدا با نام بارد راه اندازی کرد، به شدت نگران اینگونه مسایل بود.

با توجه به موفقیتچتجیپیتی، رقیب اصلی گوگل، راهاندازی جمینی یکی از بی سرو صداترین مراسمی بود که تا به حال به آن دعوت شدهام.

در این مراسم فقط من، از طریق زوم، و چند نفر از مدیران گوگل شرکت داشتند که مشتاق بودند بر محدودیتهای آن تاکید کنند؛ و حتی این برنامه هم خراب شد، زیرا معلوم شد که بارد در مطالب تبلیغاتی مربوط به خودش هم به سئوالی در مورد فضا پاسخ اشتباه داده است.

به نظر میرسد سایر دستاندرکان این حوزه هم از آنچه رخ میدهد سردرگم شدهاند.

همه آنها با یک موضوع دست و پنجه نرم میکنند. رزی کمپبل، مدیر سیاستگذاری اوپنایآی که سازنده چتجیپیتی است، اوایل این ماه در یک مصاحبه وبلاگی اظهار داشت که در اوپنآی حتی زمانی که جهتگیری خاصی شناسایی شود، تصحیح آن دشوار است و نیاز به دخالت انسانی دارد.

اما به نظر میرسد که گوگل روشی نسبتا درهم و برهم را برای اصلاح پیشداوریهای قدیمی انتخاب کرده است؛ و با انجام این کار ناخواسته مجموعهای کامل از پیشداوریهای جدید ایجاد کرده است.

از لحاظ نظری، گوگل پیشتاز مهمی در مسابقه بر سر توسعه هوش مصنوعی است. این شرکت تراشههای هوش مصنوعی خود را میسازد و عرضه میکند، شبکه ابری خود را دارد (که برای پردازش هوش مصنوعی ضروری است)، به حجم زیادی از دادهها دسترسی دارد و همچنین دارای پایگاه کاربری عظیمی است.

این شرکت برای کار در زمینه هوش مصنوعی کارشناسان درجه یک جهان را استخدام میکند و کار هوش مصنوعی آن در سطح جهانی مورد توجه قرار میگیرد.

همانطور که یکی از مدیران ارشد یک غول فناوری رقیب به من گفت: «تماشای کارهای اشتباه جمینی مانند تماشای شکست در لحظهای است که همه تصور پیروزی را داشتند!»

منبع: بی بی سی