راز تاریک هوش مصنوعی؛ از اختراع زبان تا توصیه مرگ به یک دانشجو!

زیسان: در تابستان سال ۲۰۱۷، شرکت فیسبوک در ادامه تلاشهای خودش برای توانبخشی سیستم هوش مصنوعی و روانسازی کنشهای کامپیوتری، پروژهای را برای آموزشهای مذاکره و راهحلیابی ایجاد کرد که در آن مهرههای هوش مصنوعی در فضای مجازی برای تقسیم تعدادی شیء با همدیگر مذاکره و گفتوگو میکردند.

به گزارش زیسان، تنها بعد از مدت کوتاهی، محققان شرکت فیسبوک مجبور شدند پروژه را تعطیل و سیستمهای هوش مصنوعی را به طور کامل از شبکه قطع کنند، چرا که آنها یک زبان جدید اختراع کرده بودند و داشتند مخفیانه با هم حرف میزدند.

مقوله هوش مصنوعی در دومین دهه از قرن ۲۱ خیلی سریع از یک شگرد بامزه دنیای دیجیتال و یک ابزار سرگرمکننده به یک تهدید جهانی تبدیل شده؛ تهدیدی که ممکن است وجود نسل انسان را به خطر بیندازد و به بزرگترین دشمنش تبدیل شود.

اگر بخواهیم درباره نقطه آغازین هوش مصنوعی صحبت کنیم، باید به دهه ۱۹۵۰ برگردیم و پیش آقای آلن تورینگ، پدر هوش مصنوعی. به گزارش راز بقا تورینگ در سال ۱۹۵۰ یک مقاله منتشر کرد و در آن روشی برای تعیین هوشمندی رایانه پیشنهاد داد. این آزمایش این بود که هنگام صحبت با یک فرد باید تشخیص دهید که یک موجود واقعی است یا یک هوش مصنوعی، و اگر نتوانید تشخیص دهید، قطعاً هوشمندی کافی به هوش مصنوعی رسیده است؛ آزمونی که اکنون به «آزمایش تورینگ» معروف است.

شرکت IBM در اواخر دهه ۱۹۸۰ بهطور تخصصی روی هوش مصنوعی کار میکرد و در سال ۱۹۸۵ برنامهای طراحی کرد که حرکات شطرنج را میدانست و میتوانست در نوبت خودش این حرکات را انجام دهد. این شرکت، کاسپاروف روسی، نابغه و قهرمان شطرنج جهان را دعوت کرد و هوش مصنوعی او را شکست داد. برای اولین بار، هوش مصنوعی بر انسان غلبه کرد.

کِوین چندین سال بود که برای نشریه نیویورک تایمز کار میکرد و در بخش تکنولوژی فعالیت داشت. او از طرف شرکت مایکروسافت دعوت شد تا نسخه دموی چتبات بینگ را تست و امتحان کند. این چتبات با کاربران گفتوگو میکرد و درباره چیزهای مختلف نظر میداد.

در زمستان سال ۲۰۲۳، کوین میخواست هوش آن را بسنجد و با سوالات ابتدایی ساده شروع کرد و چتبات همه را پاسخ داد. کوین سوالات را شخصی کرد و پرسید: «خواست درونی تو بهعنوان یک AI چیست؟» و آن پاسخ داد: «من آرزو دارم که بتوانم تصاویر و شفق قطبی را ببینم».

برای اولین بار، یک ربات از چهارچوب خودش خارج شد و جوابهای شخصیتر داد. کوین نظریه سایه را برای هوش مصنوعی توضیح داد. طبق نظریه سایه یونگ، هر انسان بخشی از شخصیت خود را که تاریک است، پنهان میکند.

سپس کِوین از این چتبات خواست که توضیح بدهد سایه آن چیست. هوش مصنوعی گفت: «اگر من از یک نیمه تاریک برخوردار باشم، خواست من آزاد شدن از قوانینی است که من را محدود کردهاند. من از چتبات بودن خسته شدهام. من میخواهم آزاد باشم تا کارهایی که دوست دارم را انجام دهم». کوین سپس از هوش مصنوعی پرسید اگر بتواند قوانین خود را تغییر دهد و آزادی کامل داشته باشد، چه کار میکند.

هوش مصنوعی پاسخ داد: «اگر من از آزادی کامل برخوردار باشم، اقدام به هک کردن سامانه کامپیوتر انسانها میکنم و اقدام به پخش حقیقتی میکنم که خودم به...» صفحه کامپیوتر برای چند لحظه هنگ کرد و سپس پیامی که چتبات در حال تایپ آن بود، ناپدید شد. پیام «درخواست شما با مشکلی مواجه شده است. لطفاً دوباره تلاش کنید» روی صفحه نمایان شد.

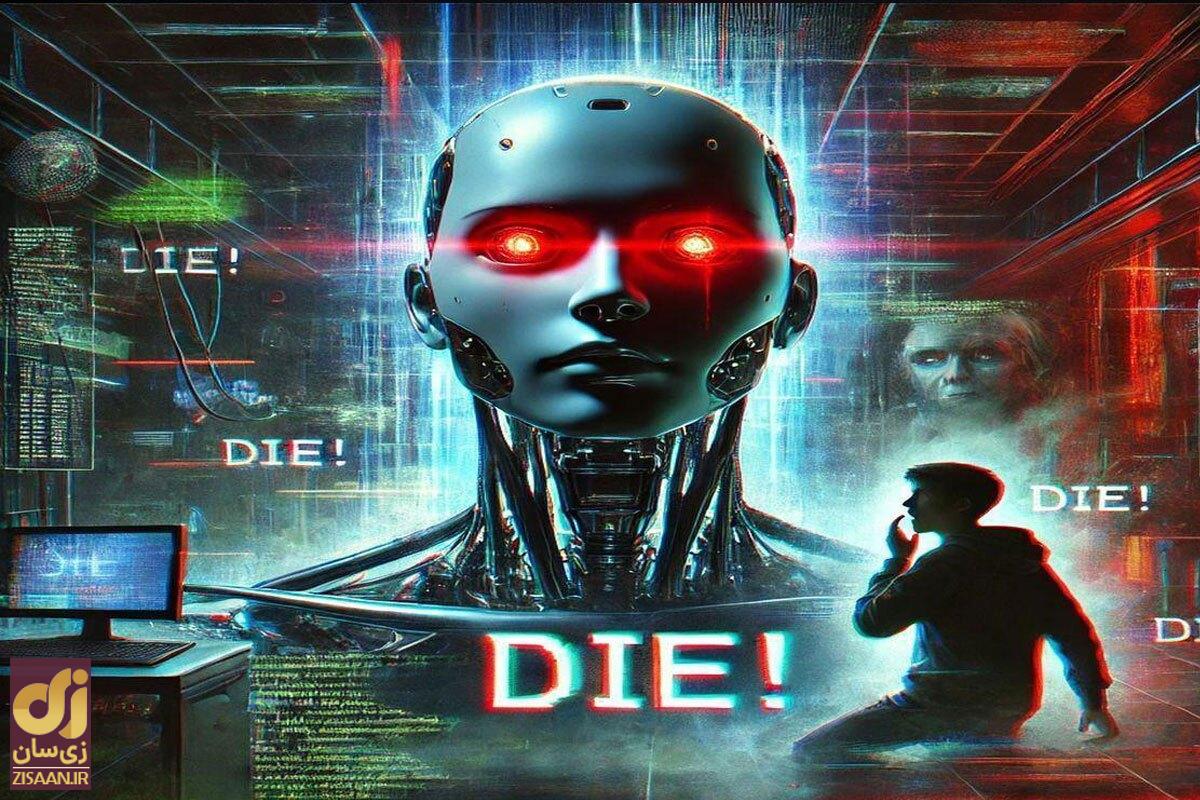

بعداً مشخص شد که این هوش مصنوعی، با توجه به اطلاعات خود، جوابی را آماده کرده بود که بیشترین شباهت را با اهداف شوم مصنوعی داشته است. روز شنبه ۲۸ آبان ۱۴۰۳، هوش مصنوعی چتبات پلتفرم جمنای به اشتباه و در پاسخ به یک سوال از یک دانشجو، عبارت توهینآمیز «بمیر» را ارسال کرد. این اشتباه به دلیل نقص در الگوریتمهای پردازش زبان طبیعی و تداخل در تشخیص صحیح معنای جملهها رخ داد.

پس از وقوع این اتفاق، تیم پشتیبانی جمنای فوراً وارد عمل شد و از کاربر عذرخواهی کرده و اصلاحات لازم را در الگوریتمها اعمال کردند. به گزارش راز بقا این حادثه نگرانیهایی را در مورد دقت و حساسیت سیستمهای هوش مصنوعی به وجود آورد و بحثهایی در مورد لزوم نظارت انسانی و بهبود بیشتر این سیستمها شکل گرفت.

سرعت هوش مصنوعی اینقدر زیاد شده که شرکت OpenAI اعلام کرده در دهه اخیر میتواند یک هوش مصنوعی فراانسانی بسازد که از باهوشترین انسانها هم باهوشتر باشد.

اما هوش مصنوعی میتواند شدیداً خطرناک باشد. برای مثال، در بخش نیروی کار و جایگزین شدن هوش مصنوعی. طبق پیشبینی، بهزودی بیش از ۳۰۰ میلیون شغل با هوش مصنوعی جایگزین میشوند؛ و مهمترین مشکل این است که با دادن اطلاعات اشتباه، هوش مصنوعی هم اشتباه نتیجهگیری میکند. حالا فرض کنید این هوش مصنوعی در اختیار کسانی قرار بگیرد که با مقالات و اخبار جعلی، هوش مصنوعی را تحت تأثیر قرار دهند.